分享发现 Migo 觅果实测:一款能自动核验参考文献真实性的知识库工具

引言:被 AI“坑” 过的科研人 作为一名技术人员或科研工作者,大家对 ChatGPT 或各类国产大模型一定不陌生。在撰写论文综述或整理技术文档时,LLM 确实是把好手。

但是,通用大模型有一个致命的 “幻觉(Hallucination)” 问题。特别是在涉及参考文献时,模型往往会基于概率预测生成一些看起来非常像真的,但实际上根本不存在的论文标题、作者和年份。

如果将这些 “幽灵文献” 写进论文或报告中,后果不仅是学术不端,更是对个人专业度的毁灭性打击。

最近,我试用了一款由上海人工智能实验室推出的工具——Migo 觅果。与市面上大多数只顾 “生成” 的工具不同,它引入了 Verification(验证)机制。以下是我的实测体验报告。

体验地址:https://migo.intern-ai.org.cn/ (建议 PC 端访问,体验更完整)

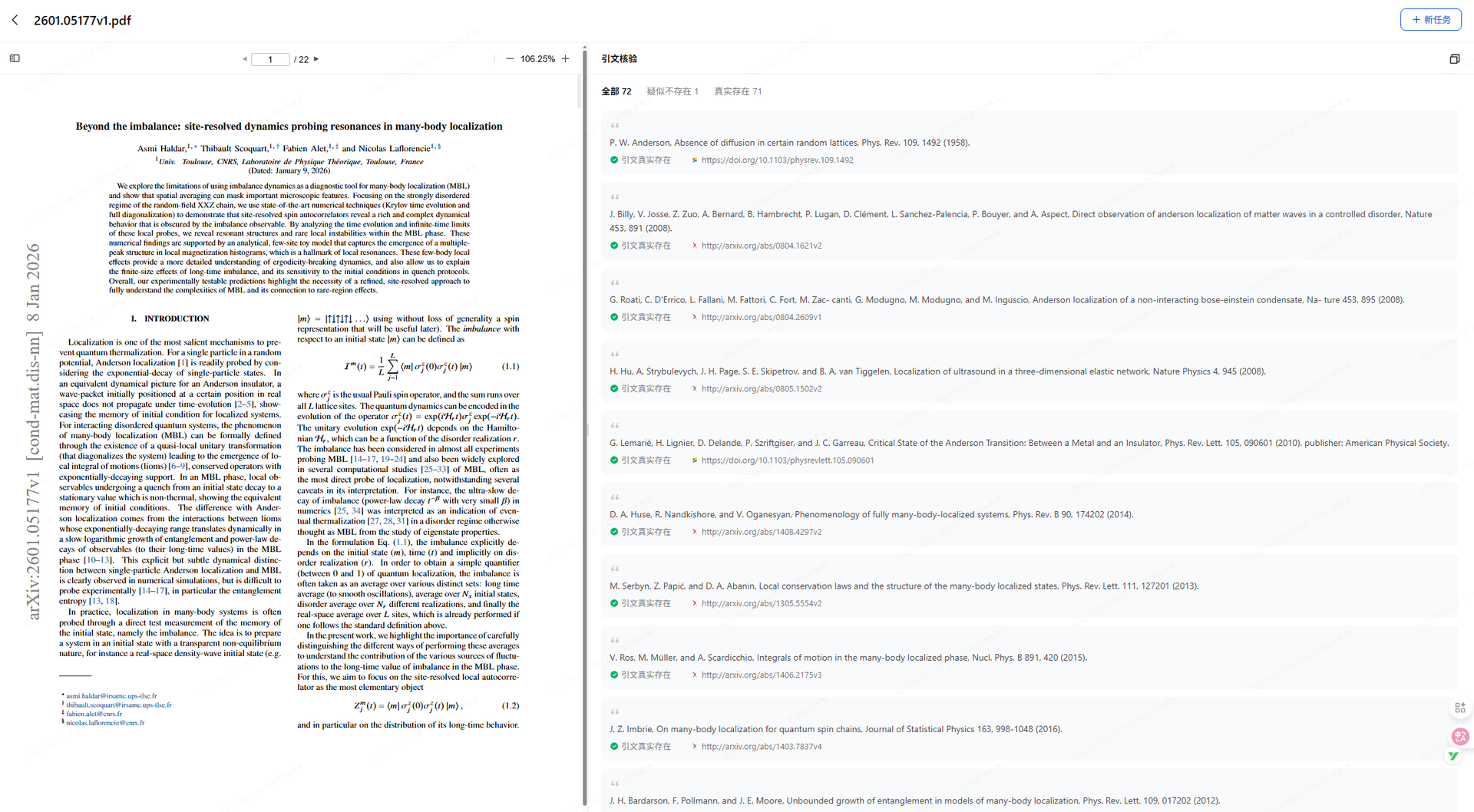

- 核心功能实测:基于真实数据库的 “引文验真” 这是该工具最差异化,也是最 “硬核” 的功能。它的技术逻辑不难理解:在接收到文档后,提取其中的参考文献列表,并利用爬虫或 API 接口与真实的学术数据库进行碰撞比对。

测试场景: 我上传了一篇由某大模型生成的包含 10 条参考文献的所谓 “综述初稿”,其中混杂了 3 条我手动编造的假文献。

测试结果: 系统上传解析速度很快。在 “参考文献” 一栏中,结果显示非常直观:

✅ 验证通过(绿色):系统在接入的 arXiv、Crossref、OpenAlex 等权威库中找到了原文,并打上了绿色的勾。

❌ 未找到(红色):我编造的那 3 条假文献,全部被识别出来,标记为 “未找到”。

(图注:Migo 后台的引文校验界面,清晰展示了真假文献的对比结果)

技术评价: 对于需要审稿的导师,或者需要自查的学生来说,这个功能极大地降低了人工去 Google Scholar 或 DBLP 逐条检索的时间成本。它相当于在一个 RAG(检索增强生成)系统中,前置了一个 Fact Checking(事实核查)模块。

此外,对于验证通过的文献,系统支持一键提取链接。点击即可直接跳转到原文出处,实现了从 “引用” 到 “溯源” 的闭环。

(图注:点击绿色链接,直接跳转至论文原文页面)

- 结构化阅读:非结构化文档的逻辑可视化 面对几十页的 PDF 论文(尤其是纯英文文献),传统的线性阅读效率很低。Migo 提供了一个 “文献伴读” 功能,利用 NLP 技术提取文章的骨架。

实测体验: 上传一篇复杂的 CVPR 论文,系统在几秒钟内生成了一张思维导图。 这张图不是简单的摘要堆砌,而是按照 “研究背景”、“核心方法(Methodology)”、“实验对比”、“结论” 等层级进行了结构化拆解。

(图注:系统自动生成的论文结构思维导图)

交互式探索: 这个导图支持启发式交互。点击图上的任意节点(比如 “Loss Function”),可以进一步向 AI 提问。系统会基于该节点的上下文给出解释。这对于快速筛选文献价值(泛读)非常有帮助。

- 个人知识库搭建:多模态数据的 RAG 实践 除了处理单篇文献,该工具也支持建立私有知识库。

目前实测支持的格式非常丰富:不仅包括常规的 PDF、Word (DOCX)、Markdown (MD)、TXT,甚至支持 PPTX 和 图片(JPEG/PNG)。这意味着你可以将课堂板书、会议白板照片、技术课件一股脑丢进去。

多库问答: 在提问时,可以选择同时索引多个知识库。系统底层应该采用了向量数据库检索技术,能够在不同文档间建立关联,回答跨文档的复杂问题。

(图注:多知识库联动问答界面)

- 总结 在 AIGC 工具泛滥的今天,“准确性” 比 “生成能力” 更为稀缺。

Migo 觅果并没有试图替代人类去 “写” 论文,而是把自己定位为一个严谨的 “审查员” 和 “助理”。对于高校师生、科研人员以及需要处理大量技术文档的工程师来说,它是一个能显著提升效率且降低合规风险的实用工具。

优点:

引文验真功能直击痛点,数据库覆盖较全。 支持图片/PPT 等多模态数据上传,兼容性好。 思维导图生成速度快,逻辑清晰。 目前完全免费,且无广告干扰。 建议: 如果你正在被 “论文查重” 或 “参考文献核对” 搞得焦头烂额,不妨试试这个工具,至少能帮你排掉 “AI 幻觉” 这个大雷。